Nel 2007, Maikl Wesch, professore di antropologia culturale presso l’Università del Kansas, ha caricato un video su YouTube che sarebbe diventato molto popolare. Era intitolato: La macchina siamo noi (ing) noi. Il testo nel mondo digitale, sosteneva Wesch, è fluido e ipertestuale, non statico. Ci costringerà a ripensare questioni come cosa significa paternità e maternità, diritto d’autore, poiché non ci saranno più un originale e una copia, l’etica della comunicazione, come sarà esercitata la governance, privacy, commercio, relazioni personali, ecc.

Ciò che Wesch e la maggior parte delle persone immaginavano all’epoca era che la tecnologia digitale ci avrebbe liberato dalle gerarchie burocratiche e avrebbe consentito alle reti non mediate di svilupparsi in un mondo più libero e creativo. Certo, Matrix era già uscito dal 1999, ma nei media è stato trattato attraverso la forma ambivalente di tecnofilia-tecnofobia. Per i media, allora ci stavamo dirigendo verso una tecno-utopia, a volte verso una tecno-distopia.

Molti anni dopo e dopo che la tecno-utopia liberale ha incontrato i suoi limiti nella repressione delle rivolte arabe del 2011-2012, le critiche ai monopoli digitali americani (GAFAM) di come stanno erodendo la democrazia, sono aumentate. Oggi sembra che ci stiamo muovendo in una nuova fase di sviluppo storico del mezzo globale di Internet, nella fase del software.

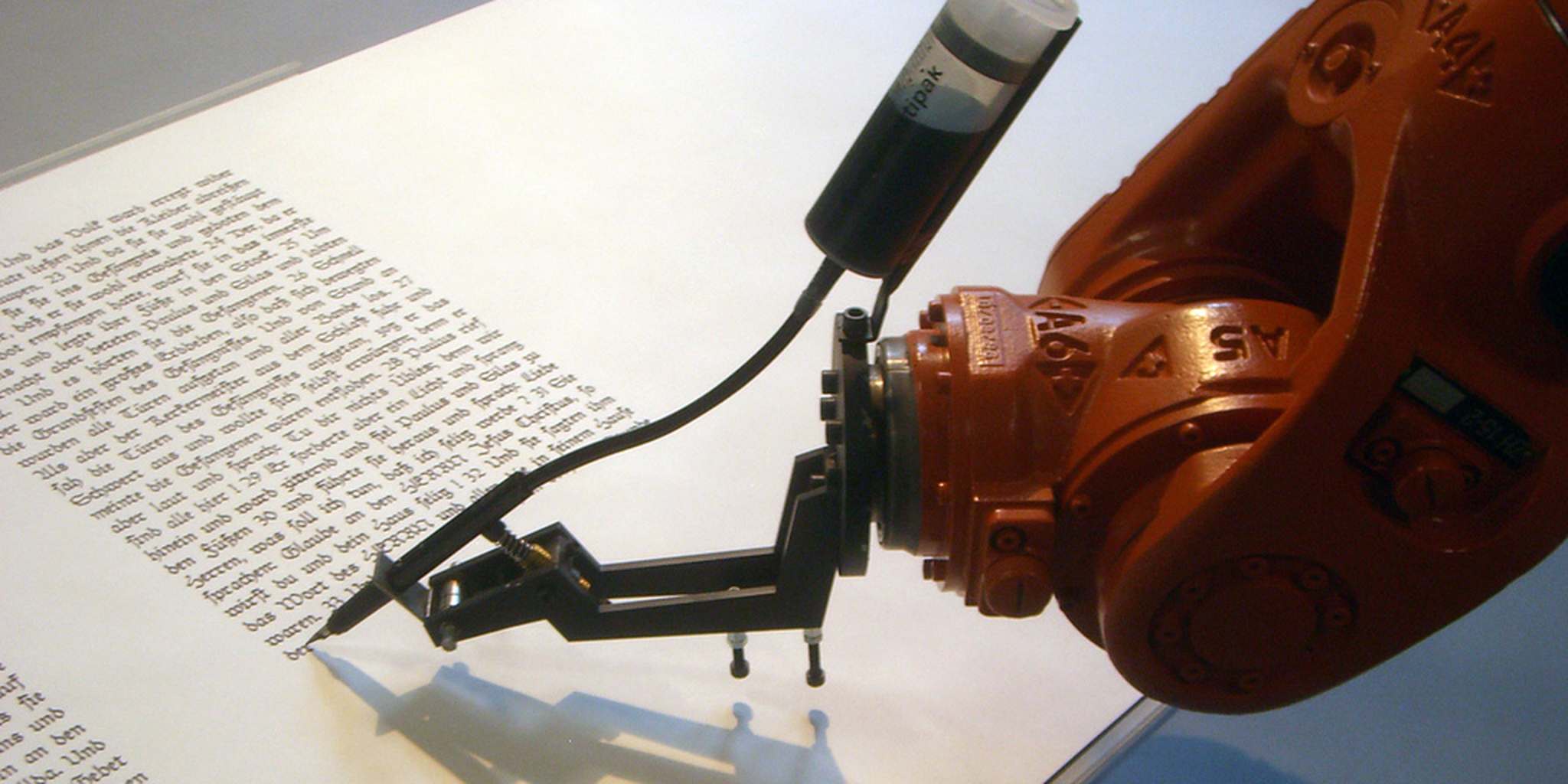

La macchina impara a parlare

Nella storia di Internet come mezzo di comunicazione globale, la prima fase del suo sviluppo ha comportato la produzione di computer e reti più veloci, lo sviluppo di software amichevoli per personal computer e world wide web e lo sviluppo di contenuti attraverso la digitalizzazione di sempre più funzioni pubbliche e private. Se a quel tempo la produzione di dati di un anno veniva confrontata con l’insieme dei testi della Biblioteca di Alessandria, oggi questa è solo una piccola frazione della quantità di dati prodotti quotidianamente. Una previsione di IDC (International Data Group) afferma che nel 2025 ci saranno 163 dati zetabit, cioè 270 byte. Nel 2018 c’erano solo 17 zetabit, mentre ogni anno vengono prodotti più dati, creando un grave problema ambientale.

Se Internet fosse un paese, sarebbe il sesto peggior produttore mondiale di anidride carbonica, secondo Greenpeace, e questa è una stima modesta del problema. Enormi insiemi di dati hanno permesso lo sviluppo di algoritmi sofisticati, che possono vedere al loro interno modelli di comportamento che altrimenti non sarebbero percepiti.

“Oggi disponiamo di enormi insiemi di dati strutturati provenienti dall’intero spettro della vita, che ci consentono di sviluppare algoritmi di apprendimento automatico, reti neurali e algoritmi di intelligenza artificiale” afferma Heraklis Varlamis, assistant professor in Data Management presso il Dipartimento di Informatica e Telematica del Harokopei Università di Atene. “Applicazioni come la categorizzazione e la descrizione di immagini e video, la traduzione linguistica e il servizio clienti specifico dell’applicazione tramite chat bot vengono eseguite in modo quasi naturale. Gli algoritmi di intelligenza artificiale hanno l’autonomia di esplorare possibili soluzioni attraverso l’apprendimento di rinforzo per selezionare quelle ottimali. Ad esempio, i robot Android e i veicoli a guida autonoma raggiungono questo obiettivo in larga misura.

ChatGPT ha “visto” 860 gb di dati, più di quanto chiunque possa leggere in una vita. Lo sviluppo di modelli statistici per la previsione di comportamenti ed esiti ha portato all’esplosione di una serie di algoritmi classificati sotto l’ombrello generale di Artificial o Extended Intelligence, secondo la definizione del MIT, ovvero: simulare i processi dell’intelligenza umana.

Negli ultimi tre anni, prima della GPT Chat di Open AI, che ha avuto 35 milioni di accessi solo nel suo primo mese sul web, c’è stata una crescita esponenziale di queste applicazioni, ma l’algoritmo GPT-3 ha portato una piccola rivoluzione dovuta alla sua tecnologia, che non si limita a esaminare i modelli statistici con una maggiore probabilità di essere corretti, ma prevede ogni parola successiva in una frase con risultati spettacolari. “Fino ad ora, avevamo diversi algoritmi per fare riepiloghi, comprensione del sentimento, ecc.”

GPT è un modello che può fare molte di queste cose contemporaneamente”, afferma Panos Karagiannis, ricercatore e proprietario di un’azienda che realizza chatbot per grandi imprese con IA. Naturalmente tutto questo ha alle spalle un enorme clamore pubblicitario da parte delle aziende che lo sviluppano. Ma allo stesso tempo non si sa come apprende una rete di computer neurale e questo stimola l’immaginazione. I computer non capiscono ancora, l’idea stessa di capire è priva di significato?

Utopia o distopia?

Tuttavia, il GPT-3 può svolgere missioni molto complesse e le sue possibilità sembrano infinite. Recentemente ha superato tutti gli esami di licenza medica negli Stati Uniti come parte di un esperimento di ricerca, ha superato un esame MBA, scrive un buon codice e programmi per computer. Ha anche avuto l’onore nella letteratura scientifica, accumulando almeno quattro contributi a articoli pubblicati e pre-pubblicazioni secondo la rivista Nature. Redattori di riviste, ricercatori ed editori si stanno già chiedendo come dovrebbero essere citati gli algoritmi di intelligenza artificiale nella letteratura pubblicata e se possono essere citati come coautori.

Pochi giorni fa la stessa rivista ha pubblicato regole d’uso e raccomandazioni per il suo utilizzo nelle Università. Tra questi si afferma che i modelli linguistici non saranno accettati come autori perché non possono assumersi la responsabilità! Un articolo sulla rivista Atlantic ha dichiarato la fine dei compiti scolastici, poiché è impossibile interrompere l’uso di questi algoritmi. Ma sia Open AI che uno studente di 22 anni di Princeton hanno rilasciato programmi che riconoscono la copia e dovrebbero entrare presto nelle università. Una piattaforma di salute mentale ha anche suscitato polemiche sui social media quando uno dei suoi dirigenti ha ammesso che la società aveva utilizzato GPT-3 per fornire consigli sulla salute mentale ai propri utenti.

Nell’ottobre 2022 l’app Koko ha utilizzato GPT-3 in circa 30.000 messaggi per circa 4.000 dei suoi utenti. Sebbene, secondo i suoi proprietari, i messaggi dell’algoritmo “sono stati valutati significativamente più alti di quelli scritti da soli umani” e “i tempi di risposta sono stati ridotti del 50% a ben meno di un minuto”, Koko ha deciso di smettere di usare GPT-3 perché “l’empatia simulata sembra strana, vuota.”

Ma perché una “non relazione” in poltrona è preferibile a una non relazione con un algoritmo? Queste sono probabilmente alcune delle domande a cui verrà data risposta nel prossimo periodo. Fino ad allora, l’autenticità nella produzione culturale probabilmente non è a rischio, come ha spiegato Nick Cave, ma anche nelle redazioni i giornalisti contano gli infiniti errori dei robot. “È estremamente costoso addestrare ogni volta l’algoritmo su contenuti live, come contenuti giornalistici, per darti bozze già pronte”, spiega Panos Karagiannis. Ciò richiederebbe enormi quantità di potenza di calcolo e non è chiaro in quale parte della produzione dovrebbe andare, tranne forse agenzie di stampa fortemente sorvegliate. Ma questo potrebbe cambiare con la creazione di computer quantistici, che dovrebbero essere completati nei prossimi anni.

Google ha paura dell’IA aperta?

L’intelligenza artificiale non è entrata nelle nostre vite con GPT, che è davvero un’evoluzione su larga scala. Un certo numero di applicazioni che usiamo ogni giorno erano già prodotti di machine learning o intelligenza artificiale. Nelle caratterizzazioni generali dell’intelligenza artificiale ci sono due categorie principali: debole e forte. La categoria di debolezza riguarda gli algoritmi che vengono eseguiti con una continua interazione con il fattore umano e sono guidati dal risultato finale.

Le applicazioni che usiamo ancora oggi erano Siri di Apple su iPhone, Alexa di Amazon, Cortana di Microsoft, ecc. Rientrano in alcune delle categorie dell’intelligenza artificiale anche gli autocorrettori nei word processor su mobile e computer, le mappe di Google con i percorsi ottimali suggeriti, i chat bot sui siti delle banche e delle compagnie telefoniche e i sistemi di riconoscimento facciale nei servizi di sicurezza.

Nelle app forti, invece, non è necessaria alcuna interazione per completare un’azione, ma sono aperte poiché l’algoritmo esegue le app da solo prevedendo le azioni giuste. Questi includono le applicazioni di navigazione puramente robotica di Google nei veicoli a guida autonoma, i robot che devono navigare su terreni naturali, come quelli di Boston Dynamics, e ovviamente l’ultimo algoritmo di intelligenza artificiale aperto GPT-3 per la generazione di testo e immagini con DALL-E.

Google, Metaverse e Microsoft sono allarmati, poiché concordano tutti sul fatto che da questo momento in poi le applicazioni di questi modelli miglioreranno e conquisteranno il mercato più velocemente di quanto l’opinione pubblica possa digerire.

Giornalismo con Intelligenza Artificiale

Pochi giorni fa Open AI ha rilasciato un altro motore di intelligenza artificiale, Whisper. Il programma trascrive automaticamente l’audio in testo da e verso l’inglese. È il sogno di ogni giornalista poter trascrivere accuratamente le proprie interviste senza dover affrontare il dolore della trascrizione. Ma questo non è l’unico cambiamento visibile che sembra probabile per la professione con l’IA.

Nelle previsioni di journalism.co.uk Charlie Beckett, professore alla LSE, prevede che il 2023 sarà l’anno in cui vedremo per la prima volta la produzione di massa di notizie sintetiche tramite algoritmi. Il termine stesso “notizie sintetiche” è interessante perché toglie il criterio della critica alla produzione della notizia. Tuttavia, le applicazioni finora non sono particolarmente incoraggianti. La rete di notizie tecnologiche CNET ha introdotto silenziosamente la generazione algoritmica del testo, ma pochi mesi dopo l’ha rimossa perché commetteva troppi errori.

Ogni giornalista sa che con l’esercizio della professione a un certo punto arrivano quelli che chiamiamo “criteri giornalistici”. È qualcosa che non si impara, ma invece si sviluppa secondo le pratiche dell’editore. Gli algoritmi di intelligenza artificiale si basano sull’apprendimento automatico quando vengono eseguiti su set di dati aperti o specifici, che rivelano gradualmente modelli di comportamento che non sarebbero altrimenti osservabili. Gli algoritmi saranno in grado di sviluppare un simile “criterio”? La risposta facile è no. Questo è qualcosa che si sviluppa all’interno di un quadro specifico di garanzie costituzionali e istituzionali, contesto professionale e sociale.

Ma è anche uno degli errori più frequenti che facciamo quando parliamo di nuove tecnologie: immaginiamo che il contesto in cui abbiamo imparato ad operare continuerà ad essere valido anche in futuro. In realtà, come spiega il giornalista Dimi Reider nel suo articolo su The Lead, non è così. Gli algoritmi non si limiteranno a scrivere le notizie, ma principalmente le detteranno seguendo le tendenze di google e degli aggregatori al fine di massimizzare il profitto.

Forse l’implementazione di algoritmi di maggior successo viene eseguita dalla rete radiofonica pubblica svedese e appartiene alla categoria dei sistemi di intelligenza artificiale “deboli”. Ogni rapporto audio è valutato dai produttori in base alle esigenze del pubblico radiofonico, come località, lunghezza, longevità, importanza, “peso o leggerezza” in quello che chiamano un “algoritmo di interesse pubblico”.

Charlie Beckett osserva che gli algoritmi sono già utilizzati in tutto il mondo per combattere le notizie false o personalizzare la segnalazione delle notizie. Il secondo è in fondo lo scopo ultimo di queste tecnologie e il modo in cui viene distrutta la condizione pregressa dell’audience nazionale a cui si rivolgono i “media tradizionali”. Questo è esattamente ciò che serve l’industria simile: la copia delle emozioni per la loro riproduzione sintetica da parte di programmi software nel mercato Internet.

Nei nostri paesi, questi sviluppi saranno probabilmente ritardati. L’industria americana in testa alla gara è principalmente interessata alle lingue principali, come l’inglese e lo spagnolo. Ma la velocità con cui si sta sviluppando questo caso ci trascinerà in un modo o nell’altro.

Di seguito è riportato un articolo* che ho scritto sul giornalismo IA utilizzando l’algoritmo di Rytr, un semplice servizio di copywriting commerciale basato sulla versione GPT-3 dell’algoritmo rivolto a inserzionisti, marketer, blogger, ecc. Durante la scrittura ho scelto parole chiave semplici come: IA, giornalismo, notizie, curatela, qualità e reportistica. Ho quindi modificato il testo mentre l’algoritmo sviluppava il ragionamento. Ho quindi elaborato la traduzione con l’algoritmo IA di Deepl, che impara mentre lo usi, con conseguenti traduzioni greche notevolmente migliorate.

Alla fine è venuto fuori qualcosa che in generale sembra corretto: il programma analizza il processo industriale di produzione di notizie per giungere a conclusioni specifiche, come la possibile produzione di nuove specialità nel settore.

Molti concordano sul fatto che questa potrebbe effettivamente essere l’evoluzione dell’editor di feed di notizie di un sito. Tra le altre cose, il programma postula che la produzione meccanica di notizie eviterà pregiudizi. Certo, l’idea che internet sia una sovrastruttura oggettiva è un pregiudizio che viene smentito dalle stesse ricerche sullo sviluppo dell’Intelligenza Artificiale. Dietro gli eccessivi titoli clickbait, a volte distopici e a volte eccessivamente tecnofili, sembra che non sia la perfezione tecnica o la completezza a dare valore alle nostre pubblicazioni, ma il giudizio dell’editore.

_________________________

In redazione con i robot*

L’idea generale del giornalismo IA è quella di utilizzare algoritmi utilizzando materia prima, che di solito richiede la revisione umana per decidere cosa è pubblicabile e cosa no. Man mano che il giornalismo passa da un formato lineare a uno più interattivo (e più coinvolgente), il ruolo del redattore di notizie cambierà per incorporare più elementi di curatela. La stesura in questo caso avverrà presentando diverse opzioni a un produttore. Ma non sarà necessariamente lui stesso a fare le modifiche — in realtà sarà più un correttore di bozze.

Uno dei principali vantaggi dell’utilizzo dell’Intelligenza Artificiale nella scrittura di notizie sarà l’esistenza di contenuti fattuali e di alta qualità, che non saranno soggetti a pregiudizi. Perché ciò avvenga è importante disporre di dati organizzati, reali e affidabili prima ancora di iniziare. Alcune società di media utilizzeranno il proprio editor di contenuti con algoritmo di intelligenza artificiale integrato per organizzare la produzione di notizie. Altri troveranno più sensato cercare di migliorare i sistemi consolidati già sul mercato.

La fusione di redattori di notizie esperti con algoritmi di intelligenza artificiale sulla linea di produzione sarà un modo per affrontare il problema della garanzia della qualità, poiché gli algoritmi incorporati verranno eseguiti con la supervisione umana. Potrebbe anche non essere necessario modificare le strutture e lo stile delle pratiche di produzione esistenti, poiché le macchine cercheranno di rilevare meglio i pregiudizi nella produzione degli articoli. L’Intelligenza Artificiale non può creare da sola contenuti originali di qualità su un argomento specifico, cosa che migliaia di giornalisti fanno ogni giorno meglio. Un computer non può sostituire una voce che vuole dire qualcosa di cultura, di politica o di economia.

La cura delle notizie diventerà una parte sempre più importante della loro produzione e creerà nelle redazioni il lavoro di redattori IA che scannerizzeranno migliaia di testi e selezioneranno quelli che saranno la materia prima per produrre articoli che porteranno più clic su un sito web. Un problema sorgerà quando l’algoritmo inizierà a diventare consapevole di sé in modo da poter selezionare i bersagli delle notizie in base ai propri modelli di analisi comportamentale. Gli algoritmi di Intelligenza Artificiale pretendono di cambiare il mondo a tutti i livelli in termini di velocità, ripetibilità e qualità. Hanno il potenziale per cambiare la qualità del giornalismo e creare una forma completamente nuova di giornalismo.

* L’articolo è stato scritto utilizzando gli algoritmi di Rytr (GPT-3) e Deepl nella traduzione. L’immagine seguente è un prodotto dell’algoritmo di Rytr.

___________________________________

___________________________________

Cosa dicono

Charlie Beckett, della LSE (London School of Economics and Political Science)

“Chat GPT è noioso, ma lo è anche molto giornalismo, noioso e prevedibile. Se ricicli i comunicati stampa, ad esempio, sul tuo lavoro, allora la macchina probabilmente funzionerà meglio a un certo punto, dal momento che sono piuttosto standard. L’integrazione di algoritmi nella segnalazione delle notizie può aiutare, ad esempio, l’editore a ottenere rapidamente informazioni sulla cronologia delle ultime notizie. Tuttavia, sebbene in genere preveda la risposta corretta, non sarai in grado di fare completamente affidamento su di essa. Ancora, ad esempio, il problema delle fake news, dei pregiudizi e del consenso non è stato risolto. Gli algoritmi IA possono rafforzare le tendenze preesistenti, come la produzione di più contenuti clickbait, ma possono anche essere utilizzati in altre fasi della produzione, tuttavia, come nella diffusione delle notizie, nella comprensione del pubblico e nelle reazioni, dovrai imparare cose nuove e acquisire nuove competenze.”

Mark Deuze, professore all’Università di Amsterdam che si occupa di applicazioni di intelligenza artificiale

“Oggi stiamo affrontando lo stesso dibattito che abbiamo avuto a metà degli anni ’90, quando ci chiedevamo quale impatto avrà Internet sulla redazione. La prima fase di introduzione di nuove tecnologie nella nostra professione è sempre dirompente. La seconda fase, quando questi cambiamenti diventano familiari, è più interessante. Nella fase iniziale dell’introduzione di una tecnologia speriamo sempre che ci liberi dalla parte faticosa del lavoro e diventiamo più creativi. Ma questo non accade, poiché il giornalismo è abbastanza prevedibile e spesso noioso per sua natura. L’impatto delle tecnologie è che stanno cambiando il modo in cui pensiamo di raccontare, documentare, pubblicare e promuovere i nostri reportage al nostro pubblico target.”

Fonte:efsyn.gr, 29-01-2023

https://www.asterios.it/catalogo/utopiadistopia