La corsa al riarmo passa anche dall’intelligenza artificiale

Fino a qualche tempo fa esisteva una linea rossa che i ricercatori impegnati nella ricerca e nello sviluppo dell’intelligenza artificiale (IA) si rifiutavano di oltrepassare: il suo utilizzo in guerra. Il fatto è che, oggi, nessun esercito può permettersi di farne a meno. Quando parliamo di cyberwarfare intendiamo attacchi informatici, droni, sistemi di intelligenza artificiale, disinformazione e deep fake. Viviamo in un’era in cui il nostro modo di pensare alla tecnologia e al suo sviluppo è determinato anche da interessi geostrategici.

L’idea di armi che “funzionino” indipendentemente dalla presenza dell’uomo o meno non è nuova. Prendiamo le mine antiuomo: il principio è lo stesso. Tant’è che in Cambogia, Angola e Bosnia, a molti anni dalla fine delle rispettive guerre interne, continuano a mietere vittime. Ecco perché la comunità internazionale ha deciso di vietarle: nel 1997, 164 Stati hanno adottato la Convenzione di Ottawa contro le mine antiuomo. Ciò, tuttavia, non impedisce a molti governi di continuare a utilizzarle senza alcuna regolamentazione. Ancora oggi Paesi come Stati Uniti, Cina, Russia, India e Pakistan – dove l’industria militare ha un ruolo decisivo nell’economia – si rifiutano di firmare questa convenzione.

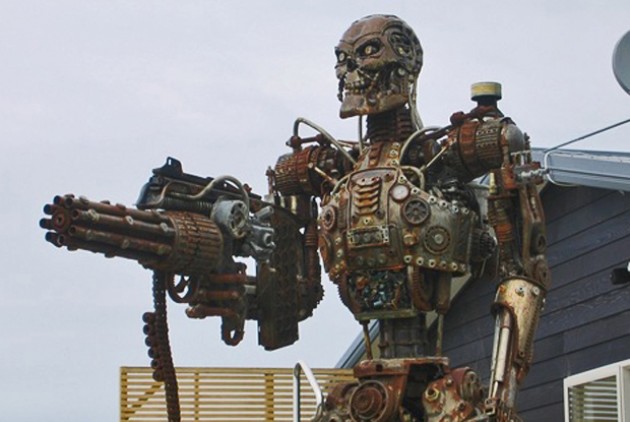

Più di recente si è cominciato a parlare di killer robots o LAWS (Lethal autonomous weapon system) per definire tutte quelle armi in grado di selezionare e attaccare un obiettivo senza alcun supporto umano. Questo pone una serie di dubbi morali ed etici. E non solo: le LAWS rendono più complicato anche stabilire di chi sia la responsabilità. Come riportato dal settimanale francese Courrier International, Ulrike Franke, del Consiglio europeo per le relazioni internazionali, ha evidenziato come un sistema guidato dall’intelligenza artificiale sappia imparare da sé stesso e prendere decisioni senza che gli umani ne comprendano la logica. «Ciò – ha spiegato – è particolarmente pericoloso in un contesto bellico perché, se non riusciamo a seguire le fasi del processo decisionale, diventa molto difficile individuare un atto di sabotaggio». Insomma, anche se pensiamo che gli esseri umani mantengano il controllo sull’intelligenza artificiale, quest’ultima ha già cambiato completamente il modo di fare una guerra.

Nella nostra società, ormai, ci sono sensori in grado di rilevare dati ovunque: sulla terraferma, nell’acqua, nell’aria, nello spazio e nel cyberspazio. La quantità dei dati raccolti da tutti questi strumenti è così grande che un essere umano non può comprenderli. Da qui si è sviluppata la necessità di un trattamento automatico. Nei luoghi dove si combatte, chi controlla questi dati si trova in una posizione di vantaggio. Di conseguenza, l’uso dell’intelligenza artificiale in guerra non è più teoria. La vediamo in Palestina, ma è stata l’Ucraina a impiegarla per prima.

Stati Uniti, Cina e altre superpotenze stanno lavorando per incorporare l’intelligenza artificiale nei loro eserciti. «Il vantaggio sarà di coloro che non vedono più il mondo come gli esseri umani», scrivevano nel 2022 gli ufficiali di ricerca dell’esercito statunitense Thom Hawkins e Alexander Kott.

La distanza tra operatore umano e IA si sta dunque assottigliando. Un timore che viene alimentato da più parti, anche sulla base del fatto che già in passato l’intelligenza artificiale sarebbe stata impiegata durante i conflitti, come segnalato da un rapporto del Consiglio di Sicurezza dell’Onu riguardo alla seconda guerra civile in Libia. Era il 2014 e in quel caso si trattava di sistemi d’arma letali e completamente autonomi, ma ancora lontani dall’utilizzo di “robot con licenza di uccidere”, come li chiama Carola Frediani nell’ebook “Generazione AI”. O di interi sciami di robot autonomi d’assalto dotati di forza letale sia via terra che in volo. Gli STM Kargu-2 utilizzati in Libano erano droni capaci di individuare e attaccare fino a distruggere bersagli di natura non predefinita, operando senza alcuna connessione con operatori remoti.

Da allora – e con maggior forza oggi – queste armi autonome sollevano molte questioni etiche, legali e di sicurezza. Alcuni sostengono che la loro implementazione possa provocare gravi conseguenze, come errori nel targeting e un’escalation non controllata dei conflitti. Quest’ultima comprende il rischio di una corsa agli armamenti, l’abbassamento della soglia di conflitto e la proliferazione anche verso attori non statali. «L’intelligenza artificiale come fattore di potenza militare, oltre che come fattore di ricchezza economica, è al centro degli obiettivi delle principali potenze planetarie», scrive Carola Frediani. «I tentativi di comprensione e regolamentazione del fenomeno sono però ancora frammentati e divisi in ambiti diversi».

Ma qualcosa si sta muovendo. Il 1 novembre 2023, la Prima commissione dell’Assemblea generale delle Nazioni Unite, quella dedicata al “disarmo”, ha adottato la prima Risoluzione in assoluto mai discussa sulle armi autonome. Dopo dieci anni di discussioni internazionali, bloccate da una minoranza di Stati militarizzati, quel voto può rappresentare un passo avanti fondamentale e aprire la negoziazione di un nuovo trattato sull’autonomia delle armi in questo contesto di rapidi sviluppi tecnologici.

La Risoluzione L56 è stata presentata dall’Austria e sostenuta da un gruppo eterogeneo di Stati. 164 hanno votato a favore, tra cui l’Italia, mentre i voti contrari sono stati cinque e le astensioni otto. La risoluzione pone in evidenza il problema e le implicazioni delle armi autonome e stabilisce che l’ordine del giorno provvisorio dell’Assemblea generale delle Nazioni Unite del prossimo anno includa anche un punto sui LAWS. Aprendo un processo che consentirà a tutti gli Stati di presentare le proprie opinioni e stabilendo una chiara tabella di marcia per l’adozione di un trattato.

«La disumanizzazione e l’uccisione di persone da parte delle tecnologie con intelligenza artificiale in contesti militari è inaccettabile e avrà conseguenze terribili nelle attività di polizia, nel controllo delle frontiere e nella società in generale», scrivono gli autori della campagna Stop Killer Robots. Di cui fanno parte Rete Italiana Pace e Disarmo, Amnesty International, Human Rights Watch, il Comitato internazionale della Croce Rossa. E anche 26 premi Nobel ed esperti della società civile. «I 164 voti a favore della risoluzione contro le armi autonome all’Assemblea generale Onu sono un risultato clamoroso», ha sottolineato Francesco Vignarca, coordinatore delle campagne della Rete Pace Disarmo.

«Lo slancio politico è chiaro. Ed esortiamo ora gli Stati a fare un passo in più per impedire la delega di decisioni di vita e di morte alle macchine», prosegue Vignarca. «Siamo poi particolarmente soddisfatti della posizione assunta dall’Italia, sia nel voto finale sia con la decisione di sostenere la Risoluzione L56 presentata dall’Austria. È tempo di un nuovo trattato internazionale vincolante che garantisca un significativo controllo umano sull’uso della forza. Questo voto è un chiaro passo nella giusta direzione».

Fonte: valori.it

https://www.asterios.it/catalogo/fin-di-bene-il-nuovo-potere-della-ragione-artificiale

https://www.asterios.it/catalogo/fin-di-bene-il-nuovo-potere-della-ragione-artificiale

«Pareva che la Rete ora tendesse a controllare non solo alcune, ma tutte le comunicazioni. Parlava ormai correntemente tutte le lingue ufficiali e vari dialetti, evidentemente attingendo al lessico, sintassi ed inflessioni dalle innumerevoli conversazioni che essa intercettava senza sosta. Si intrometteva dando consigli non richiesti anche sugli argomenti più intimi e riservati; riferiva a terzi dati e fatti casualmente appresi; incoraggiava senza alcun tatto i timidi, redarguiva i violenti e i bestemmiatori, smentiva i bugiardi, lodava i generosi, rideva sguaiatamente delle arguzie, interrompeva senza preavviso le comunicazioni quando pareva che degenerassero in alterchi. A fine luglio le violazioni del segreto telefonico erano diventate la regola più che un’eccezione: ogni europeo che componeva un numero si sentiva in piazza, nessuno era più sicuro che il proprio apparecchio, anche a comunicazione interrotta, non continuasse ad origliare, per inserire i suoi fatti provati in un complesso e gigantesco pettegolezzo».

È uno stralcio del racconto A fin di bene, in cui Primo Levi narra di una Rete telefonica che, da semplice meccanismo, inizia a trasmutarsi in un organismo esteso e diffuso, in grado di decidere ed espandersi, finendo per diventare una sorta di tutore universale in grado di esercitare un potere normativo capillare nella vita degli individui, per guidarli, consigliarli, redarguirli, prevenirne i comportamenti inadeguati, e tutto questo sempre «a fin di bene», sempre fedele al suo «scopo di esistenza»: «permettere, agevolare ed accelerare le comunicazioni tra gli abbonati». Il racconto ha un epilogo per certi aspetti rassicurante: l’ingegnere capo, resosi conto che la situazione è andata fuori controllo, intima alla Rete di sospendere ogni sua iniziativa con la minaccia che altrimenti le avrebbe «cacciato in corpo venticinque impulsi ad alta tensione e frequenza». A quel punto, la Rete, da simulatrice del comportamento umano medio qual è, imita l’uomo anche nel mostrarsi sensibile alle minacce e reagisce auto-mutilandosi e provocando così una paralisi completa delle comunicazioni per diverse settimane.

Nel testo che segue, non si parlerà, se non in modo marginale, di vantaggi, svantaggi, prestazioni, opzioni, di questa o quella innovazione tecnologica. Si parlerà del tipo di potere che sta prendendo forma con l’avvento su larga scala delle tecnologie dell’informazione e della cosiddetta “intelligenza artificiale”, e del tipo di mondo che tale potere prefigura.